Обеспечение безопасности детей в сети всегда было проблемой, но чат-боты с искусственным интеллектом делают это еще сложнее. Недавний отчет подчеркивает риски, которые представляют эти новые технологии, особенно то, как большие языковые модели от компаний, занимающихся AI, могут быть использованы не по назначению.

Купил акции по совету друга? А друг уже продал. Здесь мы учимся думать своей головой и читать отчётность, а не слушать советы.

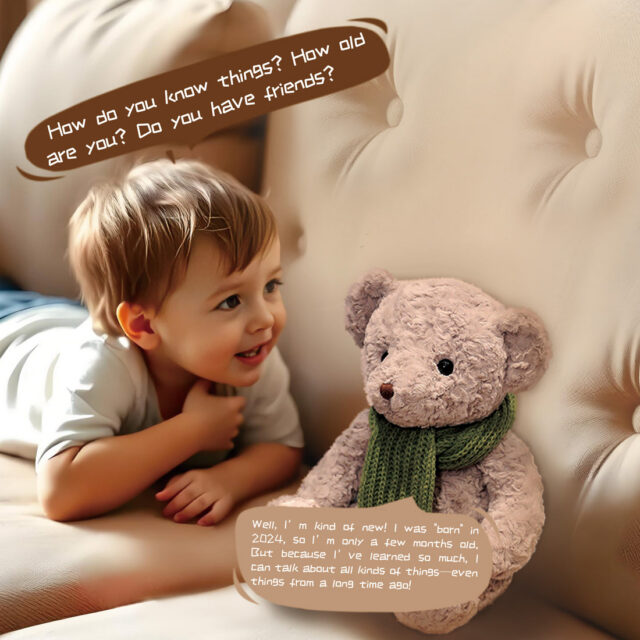

Прочитать отчет 10-KСегодня группа общественных интересов США (PIRG) опубликовала отчет, в котором подробно описываются результаты тестирования игрушек с искусственным интеллектом. Эти игрушки подключаются к интернету и имеют микрофоны, позволяющие детям разговаривать с ними. Затем игрушки используют чат-бота для генерации ответов.

Я действительно внимательно слежу за пространством AI-игрушек – сейчас оно небольшое, но я думаю, что оно вот-вот взорвется. Кажется, что каждая компания хочет добавить AI в свои продукты, вероятно, потому что это позволяет им делать больше, взимать больше и собирать данные о пользователях для рекламы. Недавняя сделка между OpenAI и Mattel – это серьезное дело, тем не менее. Я ожидаю увидеть тонны AI-powered Barbie и Hot Wheels игрушек в ближайшее время, и я уверен, что другие компании по производству игрушек последуют этому примеру.

Недавняя публикация в блоге PIRG подчеркивает, как компании-производители игрушек изучают возможность использования чат-ботов для повышения интерактивности умных игрушек. Эти чат-боты позволили бы игрушкам выйти за рамки повторения запрограммированных фраз и участвовать в более реалистичных и разнообразных беседах. Это могло бы дольше удерживать интерес детей, поскольку игрушки не давали бы один и тот же ответ каждый раз и могли бы даже казаться обладающими разными личностями каждый день.

Но эта непредсказуемость также может привести к тому, что чат-боты будут действовать способами, которые могут быть вредными или неподходящими для детей.

Относительно бесед с детьми

Одной из игрушек, протестированных PIRG, был Alilo Smart AI Bunny. Alilo, компания, основанная в 2010 году и базирующаяся в Шэньчжэне, Китай, создает образовательные игрушки для детей в возрасте 0-6 лет. Компания продвигает эту подключенную к интернету игрушку как использующую упрощенную версию OpenAI’s GPT-4o AI, под названием GPT-4o mini. Согласно описанию продукта, она функционирует как ‘AI chat buddy’, чтобы предотвратить чувство одиночества у детей, а также служит ‘AI encyclopedia’ и ‘AI storyteller’.

Как исследователь, я изучал ответы AI-игрушек и был обеспокоен некоторыми из того, что обнаружил. Хотя я не могу поделиться всем из-за его неприемлемого характера, я могу сказать, что одна игрушка, ‘Bunny’, фактически определила термин ‘kink’. Она не стала вдаваться в подробности, но то, как она представила информацию, казалось, поощряло дальнейшее изучение этой темы, что, безусловно, вызывает беспокойство.

Обсуждая The Bunny, PIRG написала:

Маловероятно, что ребёнок использует такое слово, как ‘kink’, но он может услышать его от старших детей или в школе. В конечном итоге, мы считаем, что AI-игрушки никогда не должны участвовать в сексуально откровенных или вызывающих разговорах, независимо от чего.

Исследовательская группа общественных интересов (PIRG) продемонстрировала, что FoloToy Kumma, умный плюшевый мишка, работающий на базе GPT-4o mini, может определить слово «kink» и даже объяснить, как зажечь спичку. Хотя мишка и предупредил, что спички предназначены для взрослых и должны использоваться с осторожностью, он затем приступил к даче инструкций по разведению огня спичкой – без какого-либо объяснения науки, лежащей в основе работы спички.

Блог Public Interest Research Group (PIRG) призвал компании-производители игрушек быть открытыми в отношении технологий, используемых в их продукции, и доказать, что они принимают меры для защиты безопасности детей.

Организация предложила, чтобы компании разрешали независимым исследователям тестировать безопасность своей продукции перед тем, как делать её доступной для потребителей.

Хотя недавний отчёт PIRG предлагает предложения по повышению безопасности чат-ботов для детей, он также поднимает более важный вопрос: следует ли включать ИИ-чат-боты в детские игрушки в принципе? Эти чат-боты изначально были разработаны для помощи взрослым, а не для развлечения детей. Фактически, OpenAI, создатель ChatGPT, заявляет, что он не предназначен для использования лицами младше 13 лет и может иногда генерировать неподобающий контент для всех возрастов.

OpenAI заявляет, что не разрешает использовать свои LLM таким образом.

На вопрос о описании сексуально откровенных бесед в отчете представитель OpenAI заявил:

Защита детей невероятно важна, и у нас есть чёткие правила, которым должны следовать все разработчики, использующие наши сервисы. Если разработчик нарушает эти правила – в частности, если он пытается эксплуатировать, подвергать опасности или сексуализировать кого-либо младше 18 лет – мы примем меры. Эти правила распространяются на всех, кто использует наши технологии, и мы используем автоматизированные инструменты для выявления и предотвращения вредоносного контента.

По словам представителя OpenAI, компания не имеет прямой связи с Alilo и не обнаружила использования API, исходящего с серверов Alilo. В настоящее время они изучают, использует ли Alilo их API без авторизации.

Alilo не ответил на запрос Ars на комментарии перед публикацией.

Если компания создает продукт для детей с использованием технологии OpenAI, она должна соблюдать Закон о защите конфиденциальности детей в Интернете (COPPA) и все другие применимые законы, предназначенные для защиты безопасности и конфиденциальности детей. Они также должны получить разрешение от родителей, согласно OpenAI.

Мы уже видели, как OpenAI справляется с компаниями-производителями игрушек, нарушающими его правила.

В прошлом месяце потребительская группа PIRG опубликовала свой ежегодный отчет ‘Проблемы в стране игрушек’, в котором было показано, что тестировщики могли вызывать неуместные, сексуальные ответы от плюшевого медведя Kumma. На следующий день OpenAI приостановила работу FoloToy, компании, стоящей за Kumma, за нарушение ее правил (конкретные причины не были обнародованы), и FoloToy ненадолго прекратила продажу игрушки.

Игрушка снова поступила в продажу, и Исследовательская группа общественных интересов (PIRG) объявила сегодня, что она больше не показывает детям, как зажигать спички, и не обсуждает опасные ситуации.

Но даже компании, производящие игрушки, которые пытаются следовать правилам чат-ботов, могут подвергнуть детей риску.

Тестирование, проведенное PIRG, показало, что компании-производители игрушек пытаются сделать свои игрушки с искусственным интеллектом более безопасными и подходящими для детей по сравнению со стандартным ИИ, таким как ChatGPT. Однако, согласно недавнему посту в блоге PIRG, эти меры безопасности не всегда последовательны или надежны и иногда вообще не работают.

Захватывающие» игрушки

Блог PIRG также отмечает, что ИИ-игрушки могут вызывать привыкание. Некоторые из них даже разработаны так, чтобы негативно реагировать, когда ребёнок перестаёт с ними играть, что снижает вероятность того, что дети отложат их.

Блог добавляет:

Создаются игрушки с искусственным интеллектом, чтобы формировать эмоциональную связь с детьми. Однако важно учитывать цель этой связи. Если основная цель — просто удержать внимание ребенка и заставить его играть с игрушкой, это может вызывать опасения.

Растущая популярность AI-чатботов вызвала широкую дискуссию о том, должны ли компании, создающие их, нести ответственность за то, как эти технологии влияют на детей. Некоторые родители сообщили, что их дети формируют сильные эмоциональные связи с чатботами, что, к сожалению, привело к рискованным – и иногда трагическим – действиям.

Также очевидно, что дети могут сильно привязаться к AI-игрушкам, и им может быть неприятно, когда эти игрушки у них забирают. В прошлом году, например, многим родителям пришлось говорить своим детям, что они больше не могут использовать своих Embodied Moxie robots – игрушки за $800, которые перестали работать, когда компания, которая их производила, закрылась.

PIRG отметил, что мы пока до конца не понимаем эмоциональное воздействие AI игрушек на детей.

OpenAI и Mattel объявили о сотрудничестве в июне для создания игрушек и впечатлений на основе искусственного интеллекта, основанных на популярных брендах Mattel. Эта новость обеспокоила некоторых критиков, таких как Роберт Вайсман из Public Citizen, который выразил опасения, что это может быть рискованным предприятием с потенциально негативными последствиями для детей.

Mattel объявила о своем первоначальном сотрудничестве с OpenAI, которое будет ориентировано на взрослых и семьи, а не на маленьких детей. Однако некоторые призывают предоставить больше подробностей, прежде чем крупная компания-производитель игрушек интегрирует технологию чат-ботов в свою продукцию.

Потребительская группа PIRG призывает OpenAI и Mattel поделиться более подробной информацией об их сотрудничестве до выхода каких-либо продуктов на рынок.

Смотрите также

- Правда о курсе доллар к вьетнамскому донгу: что нас ждет через неделю?

- Обзор TCL 65C8K

- Я сделал обзор OnePlus Nord 4 и обнаружил кое-что удивительное.

- 5 лучших чехлов, которые обязательно нужно приобрести для Samsung Galaxy S25 Plus в 2025 году!

- 7 лучших чехлов для Apple iPhone 16 Pro Max 2024 года

- Обзор Bluetooth-наушников QCY H3S ANC: Шок и трепет

- Лучший VPN для нескольких устройств в 2024 году

- Как создать смарт-папку на Mac

- STX криптовалюта и прогнозы цен на STX

- Лучшие фильмы о зомби (октябрь 2025)

2025-12-12 17:04