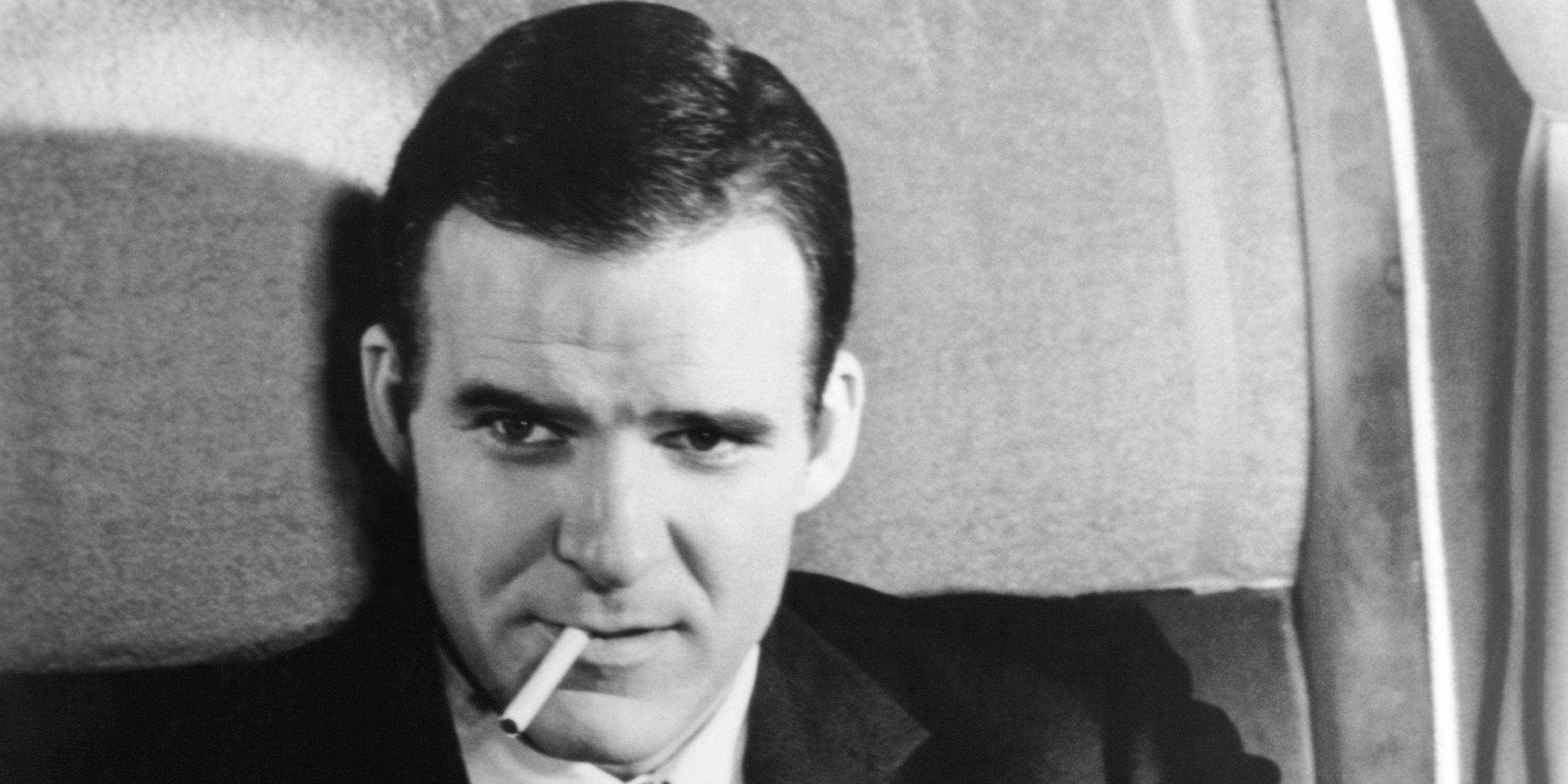

Фильм Стива Мартина «Мёртвые не носят клетку» — почти идеальная пародия на детектив.

Стив Мартин стал популярной звездой детективного жанра в 2020-х благодаря своей главной роли в сериале Hulu Only Murders in the Building, привлекая новую, более молодую аудиторию. Но, оглядываясь на его долгую карьеру, можно обнаружить интересные связи с его текущей работой – особенно уморительную криминальную пародию 1982 года, которая повлияла на многие будущие комедийные детективы.